Tercer Milenio

En colaboración con ITA

Minería de argumentos

Inteligencia artificial para analizar sentencias

El estudio de casos es un clásico del derecho. Ahora, podría automatizarse gracias a la aplicación de inteligencia artificial al ámbito jurídico. El Laboratorio Jurídico-Empresarial de la Universidad de Zaragoza y los expertos en big data de Itainnova están ya entrenando un sistema que permitirá conocer la frecuencia con que aparece cada argumento y en qué sentido se aplica.

Dentro de poco no hará falta leerse una resolución judicial para extraer conclusiones: qué se pedía, qué argumentos se utilizaron y qué sentenció el tribunal. Juristas y expertos en big data trabajan codo a codo en un proyecto pionero en España que utiliza procesamiento de lenguaje natural (NLP, Natural Language Processing) para la extracción automatizada de conocimiento de textos jurídicos. Para que las máquinas aprendan a hacerlo, la inteligencia artificial va a aplicarse a sentencias referidas a la custodia (compartida o individual) de los hijos menores de edad.

Si se obtienen buenos resultados, se pondría en manos de los investigadores una potente herramienta de ‘minería de argumentos’ aplicada a la argumentación jurídica, así como para analizar –tanto desde una perspectiva académica como sociológica– las resoluciones judiciales de los tribunales aragoneses y españoles.

El sistema "no solo identifica argumentos, sino también cuáles han sido las peticiones realizadas por la parte actora y la decisión que el tribunal ha tomado sobre las mismas, así como el género de las partes", explica José Félix Muñoz Soro, coordinador del proyecto. Podemos saber, por ejemplo, "si la sentencia trata de una madre que pide la custodia individual y si el tribunal se la otorga, así como los argumentos en que este ha basado su decisión. De esta forma será posible estudiar cómo resuelven los tribunales los asuntos sobre custodia en función de factores como el género o el tipo de pareja (hetero u homosexual), qué argumentos utilizan con mayor frecuencia y en qué sentido los aplican". En principio se prevé utilizar la herramienta para la realización de estudios jurídicos y estadísticos, pero, en un futuro, "podrían desarrollarse herramientas que, por ejemplo, ayudaran un abogado a seleccionar los mejores argumentos para fundamentar una demanda". Entre las acciones del proyecto, financiado por el Gobierno de Aragón, se plantea emplear esta herramienta para "intentar predecir, conociendo los argumentos, cuál puede ser el sentido de la decisión judicial".

Juristas e ingenieros

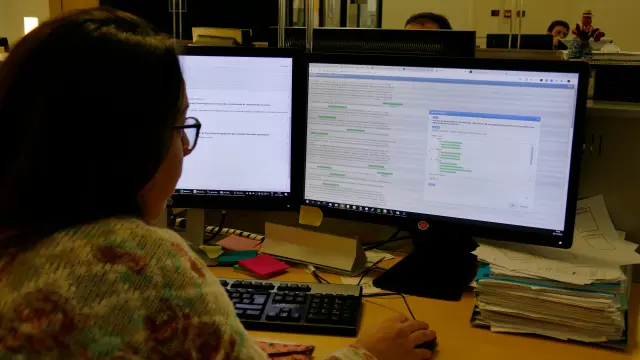

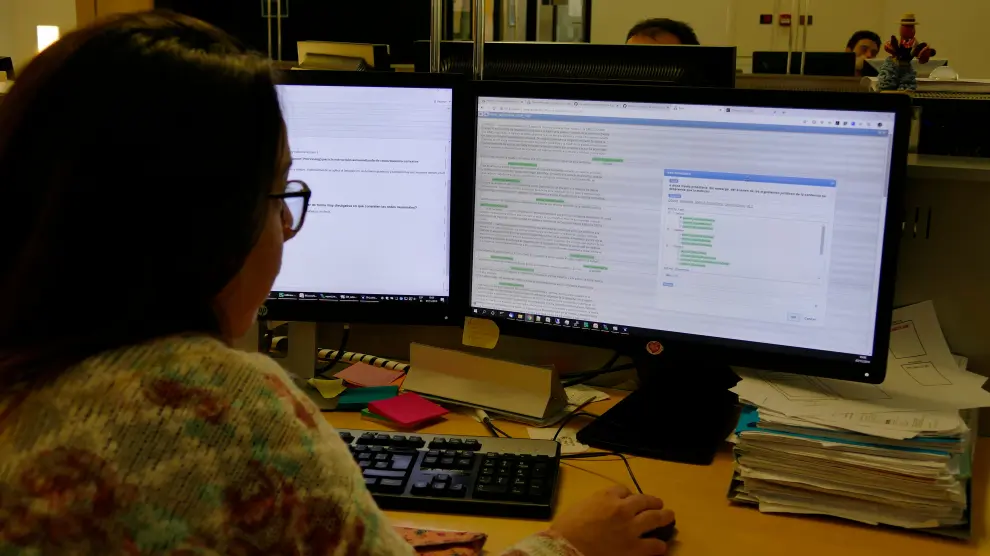

Muñoz, investigador ARAID (Agencia Aragonesa para la Investigación y el Desarrollo), coordina el proyecto ‘Análisis mediante big data de la argumentación jurídica contenida en las resoluciones de la jurisdicción civil en Aragón’, en el que unen fuerzas 12 profesores de la Universidad de Zaragoza –en su mayoría del grupo de investigación Gestión Jurídica de Negocios, Instrumentos y Organizaciones Innovadoras– y cinco investigadores de Itainnova del grupo Integración y Desarrollo de Sistemas de Big Data y Eléctricos. Dos juristas contratadas para el proyecto "se encargan del desarrollo del corpus de sentencias etiquetadas, ya que el entrenamiento de la red neuronal exige que haya un número elevado de casos ya resueltos de los que pueda aprender", indica Muñoz. Etiquetan unas 20 sentencias al día.

Se eligieron las sentencias referidas a la custodia de hijos menores "porque no es un ámbito excesivamente complejo desde el punto de vista de la fundamentación jurídica y se puede definir un número limitado de entidades que aparecen con mucha frecuencia en las resoluciones". Además, esta es la materia sobre la que hay un mayor número de sentencias (se utilizan sentencias de las audiencias provinciales de toda España, redactadas en castellano).

También tiene "mucho interés para los objetivos del proyecto el hecho de que la regulación sobre la custodia de los menores de edad no es uniforme en nuestro país", destaca. "En Cataluña, País Vasco y Valencia –y Aragón hasta la reciente promulgación de la Ley 6/2019– la legislación establece la custodia compartida como modalidad preferente", recuerda. Una vez desarrollado, "el sistema permitirá estimar cuál es el impacto real de estas diferencias normativas y en qué medida los jueces atienden a la preferencia establecida por el legislador o toman sus decisiones únicamente basándose en las circunstancias del caso".

Tanto el conjunto de sentencias etiquetadas como el modelo se compartirán, bajo una licencia libre, en el repositorio Git Hub.

Algoritmos de ‘deep learning’, ante el reto de entender el lenguaje jurídico

Aunque los algoritmos de ‘deep learning’ (aprendizaje profundo) han evolucionado mucho en los últimos años, la comprensión de un lenguaje tan complejo, en forma y fondo, como el jurídico es todo un reto. Para que una máquina entienda un texto hay algo imprescindible: etiquetas. Hay que empezar por elaborar un lenguaje de etiquetado, "el elemento fundamental tanto para el entrenamiento de la herramienta como para que esta aporte resultados", señala Rosa Montañés desde Itainnova.

Se han definido 19 etiquetas. "Hay un primer grupo de etiquetas que se refiere a las peticiones de la parte actora y a las decisiones del tribunal", detalla José Félix Muñoz. Además de la modalidad de custodia, que puede ser individual o compartida, se incluyen la asignación del uso de la vivienda familiar a uno de los cónyuges y la fijación de una pensión de alimentos. El otro grupo de etiquetas comprende los argumentos, en los que se distinguen tres tipos: los principios jurídicos, las justificaciones normativas y las justificaciones fácticas.

Desde Itannova se encargan de poner a punto la herramienta de etiquetado (Brat) "para poder generar el corpus de sentencias etiquetadas, además de diseñar y desarrollar el algoritmo de ‘deep learning’ que, una vez entrenado, podrá analizar sentencias e identificar dentro de ellas las entidades que se han definido", indica Montañés. Para ello, "utilizando el lenguaje de etiquetado, las juristas del proyecto marcan en las sentencias los fragmentos de texto que corresponden a cada entidad". Luego, con las sentencias etiquetadas por humanos, el modelo de aprendizaje profundo aprenderá a identificar esos elementos en cualquier texto. Este es el reto tecnológico.

Una vez entrenado, "el sistema, debería ser capaz de saber qué se pidió en el procedimiento, qué decidió el tribunal y en qué argumentos baso su decisión", recuerda Muñoz, pero también advierte que "ha de tenerse en cuenta que esta capacidad de comprender se limita a las entidades que se han definido en el modelo". Pero si esta experiencia inicial tiene éxito, "se abriría el camino a desarrollar sistemas que pudieran identificar cada vez más elementos en el contenido de las resoluciones".

NLP y derecho

En el campo de las ciencias sociales, "los primeros ámbitos de aplicación del procesamiento de lenguaje natural (NLP, Natural Language Processing) han sido el financiero y el márquetin, por ejemplo, valorando las perspectivas de una empresa mediante el análisis de la memoria anual o estimando la reputación de un producto mediante los comentarios en redes sociales", señala Rosa Montañés, de Itainnova. Las aplicaciones al derecho del NLP basado en ‘deep learning’ se encuentran "en una fase muy temprana y más aún en minería de argumentos". Otra de las aportaciones novedosas del proyecto es que utiliza el español, cuando la mayor parte de las experiencias de NLP se ha realizado en inglés.

Máquinas que aprenden

- INTELIGENCIA ARTIFICIAL Es la tecnología que "permite que las máquinas/computadoras aprendan a resolver tareas complejas que hasta ahora solo podíamos hacer los humanos aplicando nuestra inteligencia", explica Rosa Montañés desde Itainnova.

- DEEP LEARNING En castellano se traduce por aprendizaje profundo. Es una rama de la IA que utiliza redes neuronales, "un paradigma de computación inspirado en el funcionamiento de nuestro cerebro y orientado a aprender características de la información de entrada con distintos niveles de abstracción, para posteriormente poder realizar inferencias". Se denomina aprendizaje profundo "porque se utilizan varias capas y/o tipologías de redes (cada tipo de red suele estar especializada en extraer un tipo de patrón o características de la información que se le presenta) a las que se ‘alimenta’ con grandes cantidades de datos (big data) que sirven como ‘ejemplos/experiencias’ del mundo real, de forma que van autoajustándose progresivamente, aprendiendo de estos casos y también de sus errores".

-Ir al suplemento Tercer Milenio